I sistemi di intelligenza artificiale generativa, come ChatGPT o Gemini, stanno cambiando il modo in cui le informazioni circolano in rete. Ma pongono anche un problema serio: il diritto all’oblio rischia di essere vanificato.

Cos’è il diritto all’oblio?

Il diritto all’oblio nasce nel 2014, quando una storica sentenza della Corte di Giustizia dell’Unione Europea ha riconosciuto ai cittadini europei il diritto di chiedere la deindicizzazione di contenuti obsoleti o lesivi dai motori di ricerca. In pratica, se un’informazione non è più attuale o rilevante (ad esempio una vecchia accusa da cui si è stati assolti), si può chiedere che non compaia più tra i risultati di Google.

Da allora, milioni di persone hanno esercitato questo diritto. Solo Google ha ricevuto oltre 1,7 milioni di richieste tra il 2014 e il 2025.

Perché i chatbot “non dimenticano”?

I motori di ricerca aggiornano i propri risultati in tempo reale. I chatbot, invece, vengono addestrati su dataset statici, raccolti fino a una certa data. Se un articolo è stato rimosso dal web o deindicizzato dopo quella data, il modello AI può continuare a “ricordarlo”. È come se pescasse da un archivio congelato nel tempo.

Inoltre, i chatbot non sempre sono collegati in tempo reale al web. Anche quando lo sono, attingono da fonti eterogenee, alcune delle quali potrebbero non rispettare la deindicizzazione.

I casi concreti: quando l’IA danneggia la reputazione

Due esempi raccontati da Reputation Manager mostrano quanto sia concreta la minaccia:

- Un imprenditore assolto per corruzione scopre che un chatbot continua a collegare il suo nome a quell’accusa, nonostante la deindicizzazione da Google.

- Un manager pubblico, anch’egli assolto, vede la propria reputazione macchiata da risposte dell’IA che ripropongono notizie ormai superate.

In entrambi i casi, la reputazione digitale è rimasta “imprigionata” in una versione del passato che la legge aveva già superato.

Perché i chatbot non si aggiornano subito?

Aggiornare un modello AI non è semplice: richiede nuovi cicli di addestramento, tempo e risorse. A differenza dei motori di ricerca, non basta un click per far “sparire” un dato. E anche quando viene aggiornato, il nuovo modello può impiegare mesi per entrare in uso.

I chatbot sono fonti affidabili?

Dipende dal tipo di informazione. Se si chiede qualcosa di molto recente, e il chatbot ha accesso al web, la risposta può essere aggiornata. Ma se si tratta di fatti passati, il rischio di trovare informazioni obsolete è molto alto. E questo vale soprattutto per vicende personali, giudiziarie o sensibili.

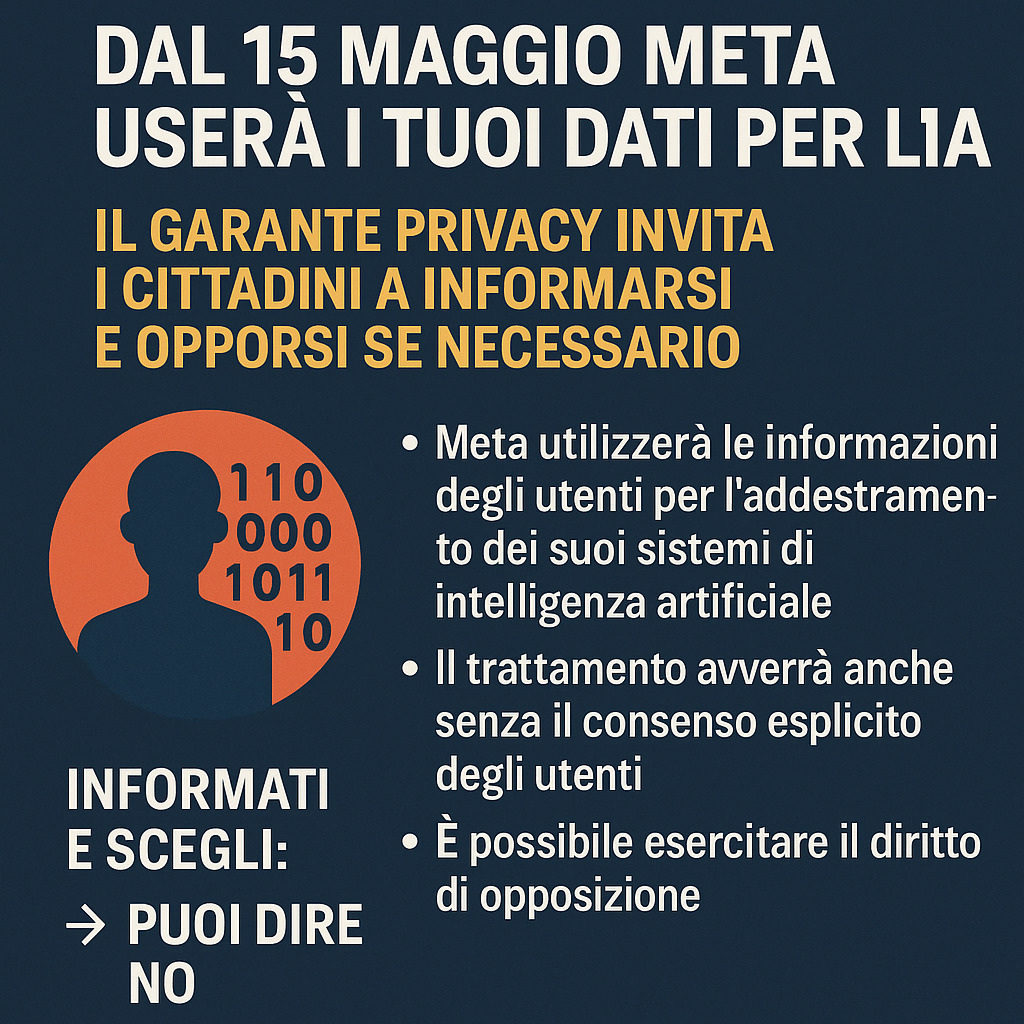

Come far valere i propri diritti?

Chi scopre che un chatbot diffonde informazioni false o lesive può agire. Ecco cosa fare:

- Contattare direttamente il provider del chatbot (es. OpenAI per ChatGPT, Google per Gemini).

- Utilizzare gli strumenti previsti per il GDPR: alcune aziende, su pressione delle autorità, hanno messo a disposizione form per chiedere la rettifica, cancellazione o aggiornamento dei dati.

- Se non si ottiene risposta entro 30 giorni, è possibile presentare reclamo al Garante Privacy.

In Italia, il Garante può avviare un’istruttoria e imporre correttivi o sanzioni.

Serve una nuova tutela legale?

Sì. Oggi siamo di fronte a un paradosso: ciò che è stato dimenticato dai motori di ricerca può essere “ricordato” dall’intelligenza artificiale. Questo rischia di rendere inefficace il diritto all’oblio, proprio mentre le persone lo esercitano per tutelare la propria dignità digitale.

Servono nuove norme, più responsabilità da parte delle aziende e strumenti efficaci per garantire il diritto a essere dimenticati anche nell’era dei chatbot. Perché senza una memoria selettiva e aggiornata, l’IA può trasformarsi in una minaccia, anziché in un supporto, alla reputazione online.