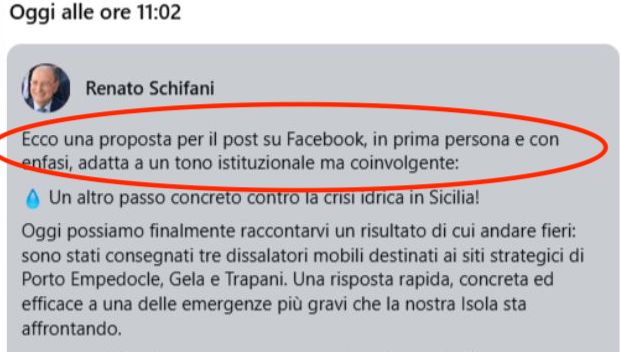

Un errore di copia-incolla, pochi secondi online, ma abbastanza per far esplodere il caso. È successo in Sicilia, dove un post pubblicato sulla pagina Facebook del presidente della Regione Renato Schifani ha rivelato — involontariamente — l’uso di ChatGPT nella redazione dei testi istituzionali. Il messaggio, che avrebbe dovuto annunciare con toni istituzionali l’inaugurazione di tre dissalatori a Porto Empedocle, Gela e Trapani, è stato pubblicato senza rimuovere la parte iniziale della richiesta fatta all’intelligenza artificiale: “Ecco una proposta per il post su Facebook, in prima persona e con enfasi, adatta a un tono istituzionale ma coinvolgente”.

Il contenuto, apparso online alle 11:02, è stato cancellato poco dopo, ma la cronologia delle modifiche e soprattutto gli screenshot condivisi su X e Instagram hanno reso impossibile contenere la diffusione della gaffe. L’errore è stato attribuito allo staff di comunicazione del governatore, che avrebbe dimenticato di editare il prompt prima della pubblicazione. Un dettaglio apparentemente banale, ma che ha riacceso un tema cruciale: fino a che punto è legittimo — o efficace — l’uso dell’intelligenza artificiale nella comunicazione politica?

Intelligenza artificiale: alleata o stampella?

L’episodio siciliano, più che una semplice disattenzione, è una fotografia efficace dell’uso crescente dell’intelligenza artificiale nel linguaggio politico. Da tempo, leader e istituzioni di ogni livello si affidano a strumenti di AI per affinare i loro messaggi, ottimizzare la presenza social, produrre discorsi o persino generare risposte ai cittadini. Non si tratta necessariamente di una novità negativa: molte amministrazioni — italiane e non — stanno sperimentando applicazioni virtuose, soprattutto in ambito informativo o partecipativo.

Tuttavia, come dimostra il caso Schifani, il confine tra supporto tecnologico e delega comunicativa può diventare pericolosamente labile. Quando l’AI diventa sostitutiva del pensiero politico e istituzionale, si rischia di trasformare la comunicazione pubblica in una sequenza di testi preconfezionati, privi di autenticità e, talvolta, di reale consapevolezza del contesto.

Dalla trasparenza alla trasparenza… algoritmica?

Il vero nodo non è se si usi l’intelligenza artificiale, ma come e con quali cautele. È evidente che, soprattutto in ambito istituzionale, serve una riflessione seria sull’impiego etico e trasparente degli strumenti generativi. L’autenticità della comunicazione politica — già spesso minacciata da spin e consulenze aggressive — rischia di essere ulteriormente indebolita da un uso disinvolto (e disattento) di sistemi come ChatGPT.

Nel caso specifico, poi, l’imbarazzo è amplificato dal tema trattato: l’emergenza idrica, una questione centrale e drammatica per migliaia di cittadini siciliani. Affidare la narrazione di una questione tanto delicata a un algoritmo — senza nemmeno la cura di ripulire il prompt — ha fatto scattare l’ironia social, ma anche una legittima preoccupazione.

Politici e AI: serve un patto di responsabilità

L’intelligenza artificiale può essere un alleato potente per chi amministra e comunica, ma non può diventare il ghostwriter universale della politica. Serve, piuttosto, una nuova cultura istituzionale dell’AI: fondata sulla consapevolezza, sulla verifica umana, e su un equilibrio sano tra innovazione e responsabilità.

E forse proprio da gaffe come questa — per quanto piccole — può nascere un dibattito più serio su trasparenza algoritmica, formazione del personale e ridefinizione dei ruoli tra umano e macchina nei palazzi del potere. Il caso Schifani è la cartolina (amara) di un presente dove l’intelligenza artificiale è entrata a pieno titolo nella macchina politico-comunicativa. Ma se non accompagnata da attenzione, formazione e trasparenza, rischia di far apparire le istituzioni più artificiali dell’AI stessa.