Nel mondo dell’intelligenza artificiale, c’è una verità scomoda con cui dobbiamo fare i conti: i modelli linguistici, per quanto avanzati, commettono errori. Non per distrazione o limiti momentanei, ma perché è scritto nel loro DNA. Le cosiddette “allucinazioni” – ossia le risposte sbagliate, inventate o incoerenti – sono un effetto strutturale, non un incidente di percorso.

Perché gli errori non si possono eliminare

I chatbot come ChatGPT non cercano la verità: predicono le parole più probabili in una sequenza di testo. Questo approccio probabilistico, basato su enormi quantità di dati testuali, genera frasi coerenti ma non necessariamente corrette. Il modello non “capisce” ciò che dice, né distingue il vero dal falso. In altre parole, simula l’intelligenza, ma non la possiede.

Come ha spiegato il professor Walter Quattrociocchi, «un modello linguistico ottimizza la coerenza statistica, non la verità. Non c’è cognizione di causa, né spirito critico. Stiamo semplicemente imparando a sfruttare la codifica del linguaggio».

Grounding, RAG e modelli valutatori: soluzioni parziali

Per ridurre le allucinazioni, molte aziende stanno investendo in soluzioni tecniche come il grounding, che consente ai modelli di attingere a fonti verificate in tempo reale. Il metodo più noto è il Retrieval-Augmented Generation, che combina la generazione automatica con informazioni tratte da database, articoli e archivi aggiornati.

Altri integrano sistemi di controllo: “mini-modelli” specializzati che valutano l’accuratezza delle risposte generate. Una sorta di seconda opinione automatica. Tuttavia, anche queste tecniche non garantiscono l’assenza di errori. Possono ridurli, ma non eliminarli.

Le implicazioni per l’informazione e il giornalismo

Nell’era dei contenuti generati dall’AI, l’informazione corre un doppio rischio: da un lato la diffusione involontaria di dati sbagliati, dall’altro una crescente fiducia cieca nei sistemi automatizzati. Man mano che questi strumenti diventano più credibili e raffinati, distinguere una verità verificata da una falsità plausibile sarà sempre più difficile.

Questo cambia radicalmente il lavoro giornalistico. Se prima il controllo della fonte era un passaggio tecnico, oggi diventa un atto culturale e politico. Serve un giornalismo capace non solo di usare l’AI, ma di interrogarla, verificarla, correggerla. L’automazione non può sostituire la responsabilità umana, né l’etica professionale.

Scrittura automatica: tra efficienza e manipolazione

Nel campo della scrittura, l’AI permette già di generare testi, riassunti, slogan pubblicitari, titoli e perfino interi articoli. Ma il rischio è che l’ottimizzazione linguistica prenda il sopravvento sul pensiero critico. Testi formalmente impeccabili possono veicolare contenuti errati, fuorvianti o semplificati all’estremo.

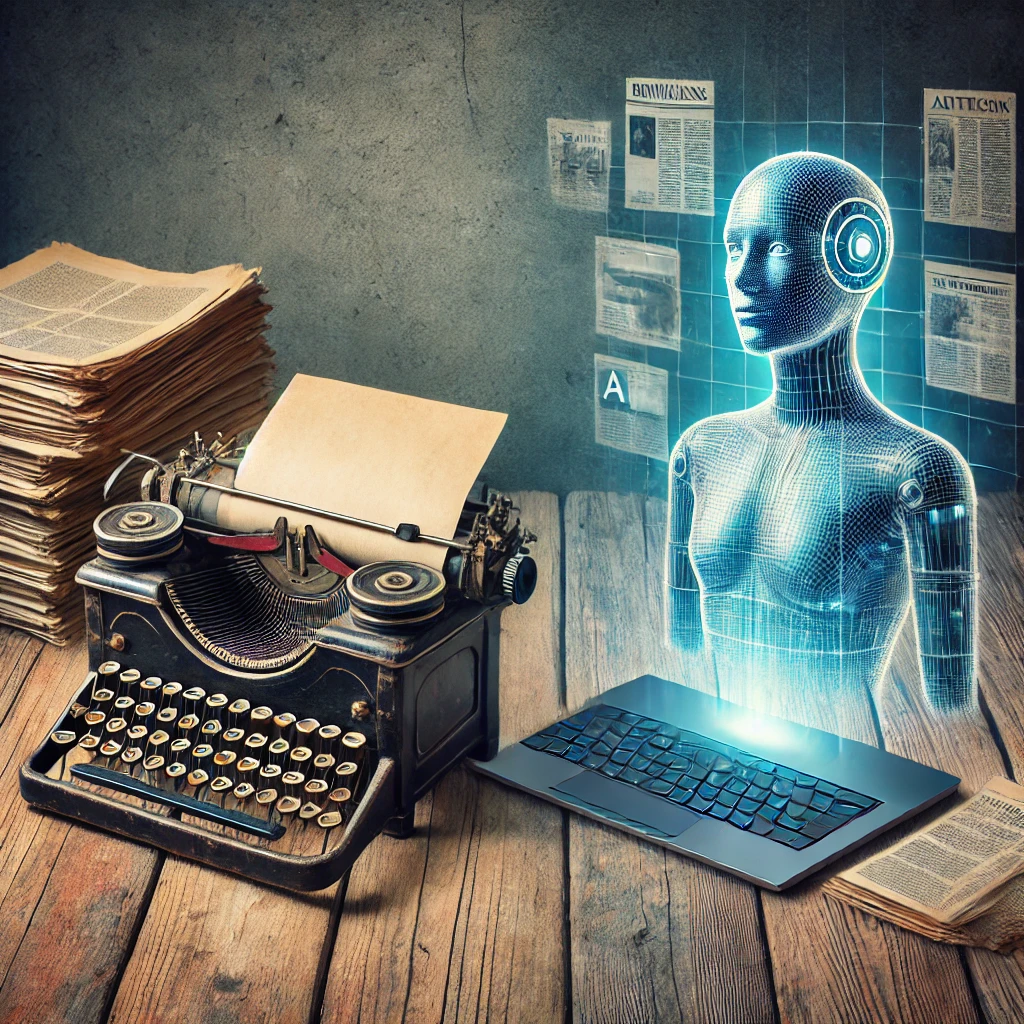

È una trasformazione profonda: scrivere non è più solo un atto creativo o informativo, ma diventa anche un’operazione ingegneristica. Chi produce contenuti oggi deve sapere come guidare il modello, selezionare le fonti, filtrare le risposte. L’abilità nel prompt diventa centrale, ma non sufficiente: senza una coscienza editoriale, la macchina può disinformare invece di informare.

Un’“intelligenza” che non è tale

La definizione stessa di “intelligenza artificiale” può trarre in inganno. Questi sistemi non pensano, non ragionano, non comprendono. Eppure, l’uso di un linguaggio antropomorfico – assistente, agente, creatività, conversazione – costruisce una narrazione ingannevole.

Come ha ricordato lo stesso Sam Altman, fondatore di OpenAI, la prudenza è d’obbligo: la nuova funzione “Agent” di ChatGPT sarà anche utile, ma meglio non darle troppe informazioni personali. Una dichiarazione che rivela quanto sia fragile l’equilibrio tra utilità e pericolo.

Verso un uso consapevole dell’AI nell’informazione

L’AI può essere una risorsa straordinaria per migliorare i processi editoriali, analizzare grandi quantità di dati e rendere accessibili contenuti complessi. Ma non potrà mai sostituire il giudizio umano, la sensibilità culturale, la verifica dei fatti.

Serve una nuova alfabetizzazione digitale: non solo imparare a usare l’intelligenza artificiale, ma anche a riconoscerne i limiti. Chi lavora con le parole – giornalisti, editori, comunicatori – deve sapere che l’AI non è infallibile, né neutra. È un interprete sofisticato, non un oracolo.

L’intelligenza artificiale generativa continuerà a sbagliare. Non per cattiva progettazione, ma per natura. Il vero progresso non sarà quello che promette perfezione, ma quello che costruisce trasparenza, controllo e responsabilità condivisa. Smettere di chiamarla “intelligenza” e iniziare a considerarla uno strumento, non un’entità, potrebbe essere il primo passo per convivere meglio con la tecnologia che abbiamo creato.